Qu'est-ce qu'un chenilleur? Les fonctions du robot de recherche "Yandex" et Google

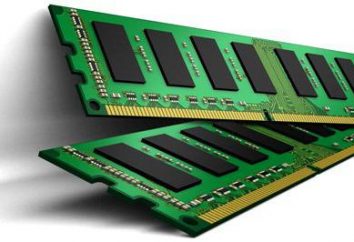

Chaque jour, beaucoup de nouveaux matériaux apparaissent sur Internet: les sites Web sont créés, les anciennes pages Web sont mises à jour, les photos et les fichiers vidéo sont téléchargés. Sans robots de recherche invisibles, il serait impossible de trouver l'un de ces documents sur le World Wide Web. Il n'y a pas d'alternatives à ces programmes robotiques en ce moment. Qu'est-ce qu'un robot de recherche, pourquoi est-il nécessaire et comment fonctionne-t-il?

Qu'est-ce qu'un chenilleur

Le robot de recherche des sites (moteurs de recherche) est un programme automatique capable de visiter des millions de pages Web, en naviguant rapidement sur Internet sans intervention de l'opérateur. Les Bots analysent constamment le World Wide Web, trouvent de nouvelles pages Internet et visitent régulièrement déjà indexés. Autres noms de robots de recherche: araignées, crawlers, bots.

Pourquoi les moteurs de recherche sont-ils nécessaires?

La fonction principale que recherchent les robots de recherche est l'indexation des pages Web, ainsi que des textes, des images, des fichiers audio et vidéo sur eux. Bots vérifient les liens, les sites miroirs (copies) et les mises à jour. Les robots surveillent également le code HTML pour se conformer aux normes de l'Organisation mondiale, qui développe et met en œuvre des normes technologiques pour le World Wide Web.

Qu'est-ce que l'indexation et pourquoi est-il nécessaire?

L'indexation – en fait, c'est la procédure de visite d'une page Web particulière par des robots de recherche. Le programme analyse les textes publiés sur le site, les images, les vidéos, les liens sortants, après quoi la page apparaît dans les résultats de recherche. Dans certains cas, le site ne peut pas être analysé automatiquement, il peut être ajouté au moteur de recherche manuellement par le webmaster. Généralement, cela se produit lorsqu'il n'y a pas de référence externe à une certaine (souvent seulement récemment créée) la page.

Comment fonctionnent les robots de recherche

Chaque moteur de recherche possède son propre robot, tandis que le robot de recherche de Google peut différer de manière significative dans le mécanisme d'opération d'un programme similaire "Yandex" ou d'autres systèmes.

En général, le principe du robot est le suivant: le programme «vient» sur le site par des liens externes et, à partir de la page principale, «lit» la ressource Web (y compris la navigation sur les données de service que l'utilisateur ne voit pas). Le robot peut se déplacer entre les pages d'un site et passer à d'autres.

Comment le programme choisit-il quel site indexer? Le plus souvent, le «voyage» d'une araignée commence par des sites d'information ou de grandes ressources, des répertoires et des agrégateurs avec une grande masse de référence. Le robot d'exploration analyse en continu les pages une par une, la vitesse et la séquence d'indexation sont affectées par les facteurs suivants:

- Interne : Remplissage (liens internes entre les pages d'une même ressource), la taille du site, l'exactitude du code, la commodité pour les utilisateurs, etc.

- Externe : la quantité totale de masse de référence qui mène au site.

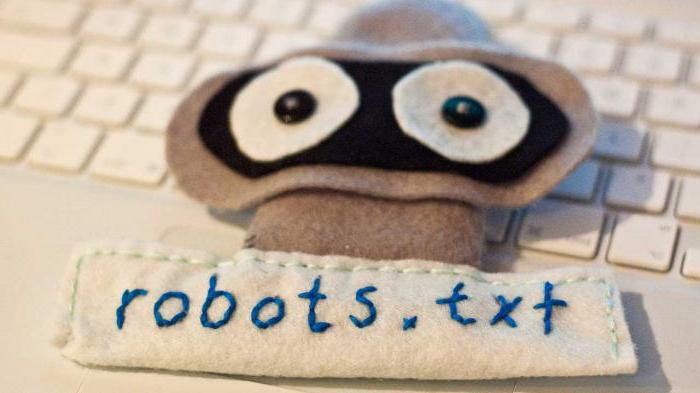

La première chose qu'un robot de recherche recherche sur n'importe quel site est un fichier robots.txt. Une indexation plus poussée de la ressource est effectuée sur la base des informations obtenues à partir de ce document. Le fichier contient des instructions précises pour les "araignées", ce qui vous permet d'augmenter les chances de visiter la page par les moteurs de recherche et, par conséquent, d'obtenir l'entrée la plus rapide possible du site dans la publication de "Yandex" ou Google.

Programmes de similarité des moteurs de recherche

Souvent, le terme «robot de recherche» est confondu avec des agents intellectuels, utilisateurs ou autonomes, des «fourmis» ou des «vers». Des différences significatives sont disponibles uniquement par rapport aux agents, d'autres définitions désignent des robots similaires.

Ainsi, les agents peuvent être:

- Intellectuelle : programmes qui se déplacent d'un site à l'autre, indépendamment de la manière de procéder; Ils ne sont pas largement diffusés sur Internet;

- Autonome : ces agents aident l'utilisateur à choisir un produit, à rechercher ou à remplir des formulaires, ce sont des filtres dits qui ne sont pas très pertinents pour les programmes réseau;

- Programmes utilisateur : les programmes facilitent l'interaction de l'utilisateur avec le World Wide Web, tels que les navigateurs (p. Ex. Opera, IE, Google Chrome, Firefox), messagerie instantanée (Viber, Telegram) ou des programmes de messagerie (MS Outlook ou Qualcomm).

Les «fourmis» et les «vers» sont plus semblables à la recherche «araignées». Les premiers forment un réseau entre eux et interagissent comme la véritable colonie de fourmis, les «vers» sont auto-reproductibles, sinon ils agissent de la même manière que le robot de recherche standard.

Variétés de robots de recherche

Il existe de nombreux types de robots de recherche. Selon le but du programme, ils peuvent être:

- "Miroir" – ils parcourent des sites en double.

- Mobile – sont destinés à des versions mobiles de pages Internet.

- Rapide – corrigez rapidement les nouvelles informations, en consultant les dernières mises à jour.

- Liens – liens d'index, comptent leur nombre.

- Indexateurs de différents types de contenu – programmes séparés pour les enregistrements texte, audio et vidéo, images.

- "Spyware" – recherchez des pages qui ne sont pas encore affichées dans le moteur de recherche.

- «Woodpeckers» – visite périodiquement les sites pour vérifier leur pertinence et leur efficacité.

- National – Parcourez les ressources Web situées sur les domaines d'un pays (par exemple, .ru, .kz ou .ua).

- Global – tous les sites nationaux sont indexés.

Robots des principaux moteurs de recherche

Il existe également des robots de moteurs de recherche distincts. En théorie, leur fonctionnalité peut varier considérablement, mais en pratique, les programmes sont presque identiques. Les principales différences entre l'indexation des pages Internet par les robots des deux principaux moteurs de recherche sont les suivantes:

- Strictness of verification. On pense que le mécanisme du robot de recherche "Yandex" est un peu plus strict sur le site pour le respect des normes du World Wide Web.

- Maintenir l'intégrité du site. Google Crawler indexe l'intégralité du site (y compris le contenu multimédia), "Yandex" peut également afficher la page de manière sélective.

- Vitesse de vérification des nouvelles pages. Google ajoute une nouvelle ressource au SERP pendant quelques jours, dans le cas de Yandex, le processus peut prendre deux semaines ou plus.

- Fréquence de réindexation. Le robot de recherche "Yandex" vérifie les mises à jour plusieurs fois par semaine, et Google – une fois tous les 14 jours.

Internet, bien sûr, n'est pas limité à deux moteurs de recherche. D'autres moteurs de recherche ont leurs propres robots, qui suivent leurs propres paramètres d'indexation. En outre, il existe plusieurs «araignées» qui ne sont pas développées par de grandes ressources de recherche, mais par des équipes individuelles ou des webmasters.

Les fausses idées communes

Contrairement à la croyance populaire, les «araignées» ne traitent pas les informations reçues. Le programme ne fait que balayer et enregistrer des pages Web, et le traitement ultérieur est effectué par des robots complètement différents.

En outre, de nombreux utilisateurs estiment que les robots de recherche ont un impact négatif et sont «nuisibles» à Internet. En effet, les versions individuelles des "araignées" peuvent considérablement surcharger le serveur. Il existe également un facteur humain – le webmaster qui a créé le programme, peut faire des erreurs dans les paramètres du robot. Néanmoins, la plupart des programmes existants sont bien conçus et gérés de manière professionnelle, et tous les problèmes émergents sont rapidement éliminés.

Comment gérer l'indexation

Les robots de recherche sont des programmes automatiques, mais le processus d'indexation peut être partiellement contrôlé par le webmaster. Ceci est grandement aidé par l'optimisation externe et interne de la ressource. En outre, vous pouvez ajouter manuellement un nouveau site au moteur de recherche: les grandes ressources ont des formes spéciales d'enregistrement des pages Web.